Datenmanagement – Der Schlüssel zur Digitalisierung

Datenmanagement zur Erhöhung des immateriellen Datenwertes, zur Verbesserung der Wettbewerbsfähigkeit und den lohnenden Einsatz von neuen Technologien.

Nach dem MIT Technology Review beherrschen Hochleistungsorganisationen Datenmanagement. Qualitativ hochwertige Daten am richtigen Ort, zur richtigen Zeit und in der erforderlichen Form sind es, die Kundenbindung fördern, die Produktivität von Mitarbeitern verbessern und Abläufe optimieren. Darüber hinaus ist Datenmanagement der Schlüssel für Digitalisierung, künstliche Intelligenz, Internet of Things, Industrie 4.0 und Data Mining um Unternehmen in wettbewerbsfähige Hochleistungsorganisationen für die Zukunft zu verwandeln. Dabei ist die Datenqualität entscheidend, denn es gilt auch hier »Garbage in, Garbage out«.

Im Unternehmen und seinem Ecosystem existieren unterschiedliche Arten von Daten:

- Allgemeine Stammdaten sind zustandsorientierte Daten, welche die Kernthemen eines Unternehmens beschreiben. Beispiele für Stammdatenobjekte sind Kunden, Lieferanten, Material, Stücklisten, Arbeitspläne, Produkte, Anlagegüter, Personal, Konten, etc.

- Zu den allgemeinen Stammdaten gehören auch Organisationsdaten: zur Strukturierung von Unternehmen für

vielseitige Zwecke (etwa Rechnungswesen) gehören die einzelnen Mandanten, Werke, Buchungskreise, Organisationseinheiten, Regionen, etc. - Jedes Stammdatenobjekt enthält verschiedene Attribute, dazu gehören Daten die längere Zeit konstant bleiben, Bewegungsdaten und spezielle Felder hinter denen Verfahren und Verweise auf Dateien abgebildet sein können.

- Stammdaten enthalten zahlreiche Attribute. Dazu gehö-ren etwa im Kundenstammsatz die Kundennummer, der Kundenname, die Kundenadresse, Ansprechpartner, etc.

Im Materialstammsatz sind es etwa der Materialname, die Materialnummer, die Materialbezeichnung, die Materialart, etc. Diese bleiben über eine längere Zeit konstant beziehungsweise verändern sich nicht. - Bewegungsdaten sind Daten wo eine »Bewegung« stattfindet, etwa Wareneingang, Warenausgang, Zahlungseingang, etc. Dazu fallen Belege an.

- Bestandsdaten sind etwa der Materialbestand, der Geldbestand, der Personalbestand, etc.

- Spezielle Felder eines Stammdatenobjekts enthalten:

- Verfahren, etwa im Materialstammsatz ein Dispositionsverfahren oder ein Bestellverfahren. Diese Verfahren sind in Tabellen hinterlegt und lösen je nach ausgewählten Verfahren in der Tabelle bestimmte Prozesse oder Aktionen aus.

- Felder zur Hinterlegung von Dateien, etwa in der Konstruktionsstückliste ein Link zu einer CAD-Datei.

Diese grundsätzliche Unterteilung der verschiedenen Datenarten zeigt die Komplexität und den Regelungsbedarf, der in nahezu jedem Stammdatenobjekt liegt.

Aber wie sieht die Praxis aus?

Werden beispielsweise Geschäftsprozesse verbessert und neue IT-Anwendungen eingeführt, wird sehr häufig das Thema Datenmanagement nicht oder nur sehr rudimentär betrachtet. Die Konsequenz: nach einer gewissen Zeit bildet sich eine schlechte Datenqualität heraus. Daten fallen in den Geschäftsprozessen an. Was passiert nun, wenn für diese Daten keine Spielregeln für die Erfassung und Pflege existieren? Über den zeitlichen Verlauf entsteht eine schlechte Datenqualität.

Worin drückt sich nun mangelnde Datenqualität und mangelndes Datenmanagement in der Praxis aus?

Dazu nachfolgend wenige, jedoch häufig in der Praxis vorkommende Beispiele in den Geschäftsprozessen:

- der Kunde erhält nicht aktuelle und inkonsistente Produktinformationen

- schlechte Auswertungen mit qualitativ verbesserungsfähigen Daten

- einzelne Mitarbeiter benötigen zu lange, um einen Report zu erstellen

- Gefahr der Spionage, denn womöglich haben zu viele Mitarbeiter Zugriff auf sensible Daten

- Diskussionen zwischen Mitarbeitern verschiedener Abteilungen über die Datengenauigkeit

- Manuelle Doppelarbeiten

Mögliche Ursachen sind:

- Aus der IT-Anwendungsarchitektur: etwa Kundendaten befinden sich in einer Vertriebsanwendung und in der Finanzbuchhaltungsanwendung. Hier können Datenredundanzen und daraus resultierend Dateninkonsistenzen vorliegen.

- Zudem können zwischen IT-Anwendungen Medienbrüche bestehen und fehlende Schnittstellen, die zu manuellen Doppelarbeiten und unbeabsichtigten Eingabefehlern führen.

- Manuelle Doppelarbeiten können also auch zu Dateninkonsistenzen führen. Darüber kann dann eine Unsicherheit bezüglich der Datenqualität bei den Nutzern entstehen.

Dies im Nachhinein zu bereinigen bedeutet einen höheren Zeitaufwand bei der Fehlerbehebung und Qualitätsverbesserung von Daten. Dies ist leider häufig in der Praxis vorzufinden. Es werden in der Praxis nachträglich Projekte zur Verbesserung der Datenqualität aufgesetzt, etwa um die Kundendatenqualität, Lieferantendatenqualität, Produktdatenqualität, etc. zu verbessern.

Darüber hinaus existieren nur teilweise oder rudimentär:

- Eine organisatorische Integration des Datenmanagements im Unternehmen bestehend aus Rollen, Gremien, Prozesse, Templates und Software für das Datenmanagement.

- Verständliche Richtlinien darüber, wer im Unternehmen auf welche Daten Zugriff hat, diese lesen, verändern, verteilen oder löschen darf.

- Spielregeln für die Löschung von Daten unter Berücksichtigung der gesetzlichen und organisatorischen Anforderungen.

- Für jede IT-Anwendung: Datenmodelle mit den Datenobjekten, den Attributen der Datenobjekte und den Beziehungen zwischen den Datenobjekten.

- Datenrepositories, Übersichten über Daten und deren Attribute.

- Die genauen Speicherorte der Daten (häufig bei virtuellen Systemen).

- ein Softwaremodul für das Stammdatenmanagement.

Aber wie kann hier geholfen werden?

Natürlich muss frühestmöglich das Thema Datenmanagement bereits in der Entstehung oder Verbesserung eines Prozesses angegangen werden. Bereits im Projekt muss dies geregelt werden mit den dazugehörigen Datenmanagement-Prozessen, Rollen, Spielregeln und Templates.

Der Königsweg ist hier die Anwendung eines Referenzmodells.

Ähnlich wie für die IT-Prozesse und die IT-Organisation und deren Referenzmodelle (etwa ITIL, CobiT, etc.) gibt es ein Modell der Data Management Association International (»DAMA«). Die DAMA (www.dama.org) ist eine internationale, anbieterunabhängige Non-Profit-Organisation, die sich aus Fachexperten zusammensetzt und das Ziel verfolgt, Konzepte für das Daten- und Informationsmanagement (weiter) zu entwickeln. Die DAMA wurde 1980 in Los Angeles gegründet. Heute sind es über 40 »Chapter« in mehr als 15 Ländern mit über 5.000 Mitgliedern (https://dama.org/browse-chapters).

DAMA bietet Mitgliedschaften für Firmen und einzelne Mitglieder an, organisiert Seminare und Konferenzen, bietet ein Zertifizierungsprogramm an und darüber hinaus Bücher (siehe Literaturliste).

Die DAMA unterteilt das Daten- und Informationsmanagement in zehn Datenmanagement-Funktionen. Die Data Governance stellt die zentrale Wissensdomäne dar und verbindet die anderen neun Themen [2]:

- Datenarchitekturverwaltung

- Datenentwicklung

- Data Operations Management

- Datensicherheitsmanagement

- Referenz- und Stammdatenverwaltung

- Data Warehousing und Business Intelligence

- Dokumenten- und Inhaltsverwaltung

- Metadatenverwaltung

- Datenqualitätsmanagement

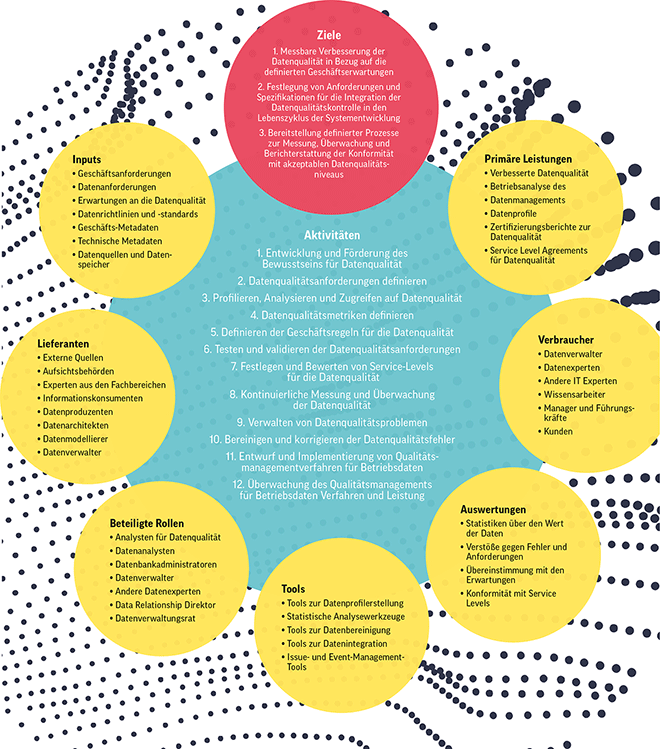

Jede dieser zehn Funktionen ist nach einer einheitlichen Struktur beschrieben. Diese Struktur besteht aus einem Kontext-Diagramm. Ein Beispiel für ein Kontext-Diagramm ist in der Abbildung zur Funktion Datenqualitätsmanagement dargestellt.

Ein Kontext-Diagramm ist im DAMA-Guide für jede der zehn Funktionen spezifisch beschrieben und darüber hinaus zusätzliche Inhalte zur Organisation und Kultur, Aktivitäten, Deliverables, Rollen und Verantwortlichkeiten, Praxisbeispielen (auch wie man etwa den Wert einzelner Datenobjekte berechnen kann) und den Technologien. Die DAMA-Bücher sind für die Projektpraxis sehr nützlich.

Für die Anwendung in Projekten bedeutet dies, nicht sofort alle 10 Datenmanagement-Funktionen umzusetzen. Wichtig sind in einem ersten Schritt häufig zwei Funktionen:

- Eine Organisationsform um Datenmanagement im Unternehmen, etwa einer Abteilung in der Fachseite und zusätzlich Datenverantwortliche in den Geschäftsbereichen aufzubauen und

- anzufangen mit kleinen Projekten zur kontinuierlichen Verbesserung der Datenqualität für ausgewählte Datenobjekte (etwa Kunden und Lieferanten).

Inzwischen haben sich »Good Practices« bei führenden Unternehmen im Datenmanagement etabliert.

Diese sind:

- Es gibt eine Data Governance, ein Modell zur organisatorischen Integration des Datenmanagements (etwa eine Datenmanagement-Abteilung oder ein Gremium für Datenmanagement) für die Geschäftsprozesse mit klaren Regeln wer Daten anlegt, ändern, verteilen, lesen darf und am Ende des Datenlebenszyklus löschen darf.

- Das Datenmanagement ist in den Geschäftsprozessen aufgehangen. Die Datenqualität ist in der Verantwortung von Data Ownern, welche an die Geschäftsprozess-Owner berichten.

- Es gibt für die »Datenverantwortlichen« Rollenbeschreibungen.

- Sofern es sich um IT-Prozesse handelt, existieren ebenfalls Verantwortliche und Rollenbeschreibungen.

- Es existieren Zielvereinbarungen für die verschiedenen Rollen in den Geschäftsbereichen und der IT-Organisation.

- In allen IT-Einführungsprojekten in denen Geschäfts- oder IT-Prozesse tangiert werden wird der Datenmanagement-Prozess mit Verantwortlichkeiten, Rollen und Templates beschrieben.

- Klare Regeln für den Umgang und die Pflege mit Daten, das heißt, wer darf anlegen, lesen, ändern, archivieren, löschen.

- Gezielter Einsatz von Good-Practice-Standards, etwa DAMA, eClass, …

- Für jedes Datenobjekt wird ein »Single Point of Truth (SPOC)« festgelegt.

- Datenqualität: automatische Prüfungen von Regeln, um gleich bei der Dateneingabe Plausibilitätsprüfungen durchzuführen.

- Es existiert eine »4-Augen-Regel« für die Freigabe eines einzelnen Stammdatensatzes.

- Es sind Datenklassifikationen eingeführt, etwa Materialklassifikation, Equipment-Klassifikation, etc.

- Es sind spezielle Softwarepakete für das Stammdatenmanagement eingeführt.